2017-10-260 komment

Mi az az A/B teszt? Hogyan végezz el egy tesztet 15 lépésben?

Tartalomjegyzék

Amikor elkészítesz egy landing oldalt, összeállítasz egy e-mailt vagy csak megtervezel egy új call to action gombot, sokszor csak a megérzéseidre hagyatkozol azok kialakításánál. Ez azonban nem elég hatékony megoldás, egy A/B teszt megbízhatóbb eredményeket hoz. (Frissítés, 2021.04.14. – Egy új fejezettel bővítettünk: Hogyan A/B tesztelj, hogy az ne zavarja a Google-t?).

Az A/B tesztekre azért lehet szükséged, hogy meggyőződj arról, a megfelelő döntést hoztad a design során, és ehhez kapcsolódóan a konverzióoptimalizálás miatt. Ahelyett, hogy feltételezésekre és érzésekre hagyatkozva hoznál meg súlyos következményekkel járó döntéseket, jobban teszed, ha tesztelsz. Az egyes célközönségek ugyanis nem egyformák, és főleg nem azonosak veled vagy a kollégáiddal. Ami az egyik esetben működik, az nem feltétlenül lesz működőképes más körülmények között.

Hogyan működnek az A/B tesztek?

A teszteknek is megvan az a veszélye, hogy rossz következtetéseket vonsz le belőlük, így hibás lesz az egész stratégiád. Még egy A/B tesztet is el lehet rontani, ha rossz a kiindulópontod (erről egy külön fejezetben ejtünk szót). Pedig ez a legegyszerűbb teszt-típus. Ilyenkor mindössze annyit kell tenned, hogy egy verzióval szembeállítasz egy másikat, majd méred a különbséget. Például megvizsgálod, hogy egy zöld vagy egy piros színű CTA-ra kattintanak-e inkább az emberek. Ilyenkor persze kérdésként felmerülhet, hogy érdemes-e ezt tesztelni? Amire a bejegyzés végén még visszatérünk.

Ahhoz, hogy futtatni tudj egy A/B tesztet, szükséged lesz valamely tartalmi elemedből két verzióra, melynél csak egyetlen dolog esetében mutatkozik eltérés a másikhoz képest. Ezt a két verziót két hasonló méretű csoportnak kell prezentálnod, majd elemezned, hogy melyik verzió teljesített jobban.

Tehát, például szeretnéd tudni, hogy egy hajtás felett elhelyezz call to action gomb jobban teljesít-e, mint a lap alján elhelyezett CTA. Ennek A/B tesztelése úgy történik, hogy elkészíted mindkét verziót egy-egy weboldalon. A gyakorlatban az egyik általában a meglévő designod, míg a másik a kihívója, egy új megoldás. Mindkét verzió esetében egy nagyjából ugyanakkora méretű látogatócsoportnak kell használnia mindkét verziót. A teszt végén a kapott adatokból kiderül, hogy melyik megoldásnál volt több kattintás a CTA-ra. Ahol több a kattintás, az a nyerő verzió. De lássuk a folyamatot lépésekre bontva!

Mit tegyél az A/B teszt indulása előtt?

1. Válassz ki egy verziót tesztelésre!

A weboldalad vagy az e-mailjeid optimalizálása közben általában azzal az igénnyel találkozol, hogy többféle ötleted is született, melyeket tesztelni szeretnél. Ahhoz azonban, hogy valóban rájöjj, pontosan mi okoz eltérést a hatékonyságban, egyszerre mindig csak egyetlen változtatást szabad eszközölnöd. Így tudod csak pontosan mérni a teljesítményét.

Ha több dolgot változtatsz meg egyszerre, akkor nem fogod tudni, hogy melyik, milyen irányú változást okozott. Egyszerre tehát mindig egy módosítást tesztelj! Tartsd észben, hogy még a legkisebb változtatás is – akár egy kép cseréje – is jelentős eltérést eredményezhet a számokban! Léteznek persze olyan, többváltozós tesztek, ahol nem csak egyetlen elem változását próbálják mérni, ez azonban nem az A/B tesztek köre.

2. Határozd meg a célod!

Habár minden tesztnél több számot is figyelni fogsz, érdemes egy elsődleges adatra fókuszálni, még mielőtt elkezdenéd a tesztet. Már azelőtt célszerű kiválasztani azt, hogy mi az, ami számodra különösen fontos, mielőtt szembeállítanál egy variációt az elsővel.

Ha csak a teszt után határozod meg azt a mutatót, ami fontos számodra, ekkor határozod meg a célt, és gondolod végig, hogy a javasolt változások miként befolyásolhatják a felhasználói viselkedést, akkor lehet, hogy nem sikerül a leghatékonyabban kivitelezned a tesztet.

3. Találd ki a “kontroll” és a “kihívó” verziót!

Bármit is tesztelsz, mindig a jelenlegi állapotú verzió legyen a “kontroll” verzió. Ha például egy weboldalt tesztelsz, akkor a kontroll verzió a már létező weboldal lesz. Ezután hozz létre egy ehhez képest megváltoztatott verziót, mely a “kihívó” lesz.

Tehát ha például arra vagy kíváncsi, hogy egy landing oldalon érdemes-e elhelyezned korábbi vevők ajánlását, akkor a kontroll oldaladon még nincs meg az ajánlás, viszont a kihívó variáción ez megjelenik, így mérheted a hatását a megrendelésekre.

4. A mintacsoportokat véletlenszerűen válaszd ki és egyforma méretűek legyenek!

Az olyan teszteknél, ahol megvan a teljes befolyásod a tesztcsoportok kiválasztására – például e-mail verziók tesztelésénél -, a helyes eredmények érdekében azonos méretű csoportokban kell gondolkodnod, melyek tagjait véletlenszerűen válogatod össze.

5. Határozd meg a mintaméretet!

Az, hogy miként tudod meghatározni a tesztcsoportokat, az az A/B tesztelő eszközödtől, valamint attól függ, hogy milyen típusú tesztet hajtasz végre. Ha egy e-mailt A/B tesztelsz, akkor vélhetően egy kisebb csoportot veszel bele a teljes listából az A/B tesztbe, majd a maradék nagyobb csoportnak küldöd ki a nyertes verziót.

Ha viszont egy olyan dolgot tesztelsz, amelynek nincs egy véges közönségmérete – tehát például egy weboldalt -, akkor az határozza meg a mintaméretet, hogy mennyi ideig futtatod a tesztet. Elegendő ideig kell tesztelned majd ahhoz, hogy elérd a megfelelő látogatószámot, különben nehezen tudnál rámutatni statisztikailag szignifikáns eltérésekre.

6. Döntsd el, hogy mennyire kell szignifikánsnak lenniük az eredményeknek!

Ha már meghatároztad a cél-mutatót, akkor tudnod kel, hogy mikor válik szignifikánssá számodra az eredmény ahhoz, hogy az egyik verziót győztesnek kiálthasd ki. Ez egy rendkívül fontos tényező az A/B tesztelés folyamatában.

A nagyobb változások esetén kisebb mértékű sziginfikancia is elegendő, hiszen vélhetően a jelentős mértékű változtatás okozza a konverzió-javulás. Ugyanakkor apró változtatások (gombszín, microcopy) nem okoznak óriási változást a konverziós arányban, így szignifikánsabb eredmények indokolnak csak változtatást. Általában 80-98 százalékos értékeknél elfogadható a megbízhatóság, online (A/B teszt szignifikancia) kalkulátorokkal ezek az értékek könnyen kiszámíthatók.

7. Csak egyetlen tesztet futtass egyszerre!

Ha egynél több dolgot tesztelsz egyszerre, akkor összekuszálódhatnak a dolgok. Ha például épp egy e-mail kampánynál hajtasz végre A/B tesztet, ami egy landing oldalra vezet, viszont eközben ezt a landing oldalt is A/B teszteled, akkor nem jutsz semmire az eredményekkel.

Az A/B teszt során

8. Válaszd ki az A/B tesztelő eszközt!

Az A/B tesztekhez valamilyen tesztelő eszközre szükséged lesz a következő pontokban részletezett okoknál fogva. A weben találsz erre lehetőségeket, de bizonyos e-mail szolgáltatásokba (például Mailchimp) be van építve a funkció, illetve a Google Analyticset is használhatod erre a célra. Ingyenes megoldásként pedig rendelkezésre áll mindenki számára a Google-től az Optimize. De lássuk részletesen a különböző lehetőségeket!

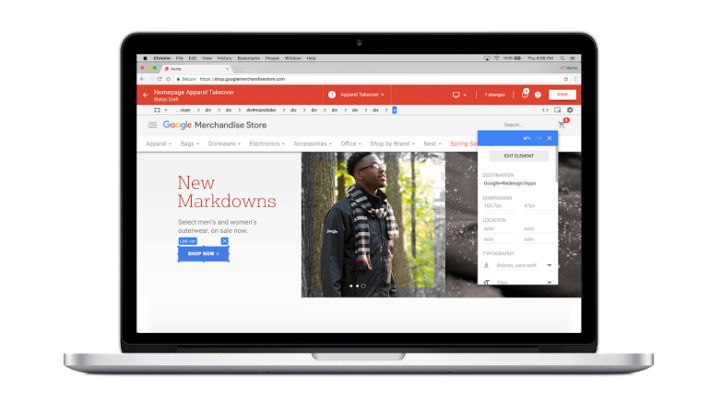

Google Optimize

Az Optimize béta verziója 2016 őszén indult, 2017 márciusában már kilépett a béta állapotból, és a világ 180 országában elérhető. A Google kifejezetten kis és közepes méretű vállalkozásoknak szánja. Az Optimize-t össze kell kötni a Google Analyticsszel, hogy az adatok segítsenek a weboldal tesztekben. Vizuális szerkesztőjében bizonyos elemek könnyen elhelyezhetők az oldalon drag and drop megoldással, de a nyers HTML kód is szerkeszthető, valamint JavaScript és CSS szabályok is hozzáadhatók.

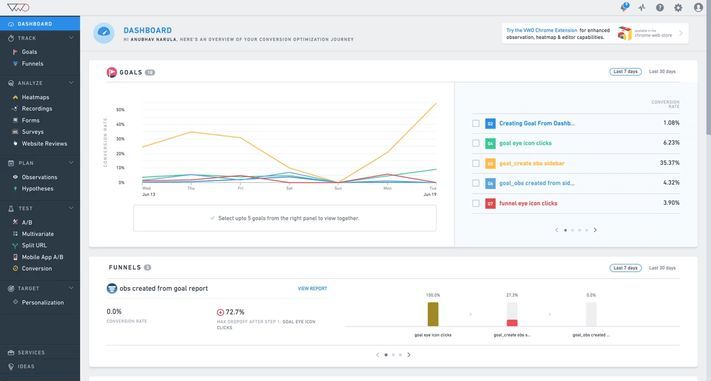

VWO

Igazi nehézsúlyú versenyző a VWO, melyet olyan cégek használnak, mint az eBay, a Target vagy a Virgin Holdays. A lehetőségek között megtalálni az A/B teszteket, az osztott URL-teszteket, a multivariációs tesztelési lehetőségét.

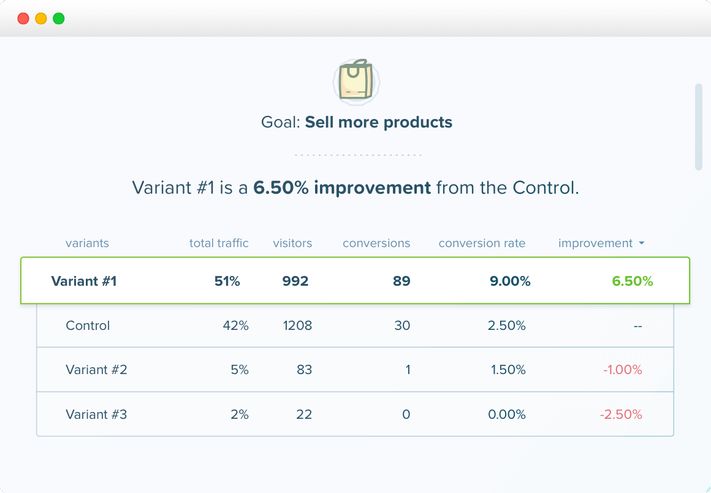

Optimizely

Az Optimizelyt a Fortune 100-ből 24 cég választotta. Multivariációs tesztek is futtathatók a segítségével, vizsgálhatók dinamikus weboldalak, különféle kísérleti dimenziókkal a kampányra, az elhelyezkedésre, a cookie-kra, valamint különböző szegmentálási lehetőségekre vonatkozóan, mint az eszköz vagy a böngésző.

Omniconvert

Az Omniconvert is egy olyan konverzióoptimalizáló platform, mely lehetőséget kínál többek között A/B tesztek végrehajtására. A tesztek futtathatók desktop vagy mobilfelületeken is. 40 szegmentációs paraméter, például forgalmi forrás, elhelyezkedés, látogatói viselkedés tesztelhető az eszközzel.

Crazy Egg

A Crazy Egg egy weboldal-optimalizáló szoftver, mely A/B teszteket, hőtérképet és egyéb felhasználói teszt-eszközöket kínál. Az A/B teszteknél különféle variációit vizsgálhatod a weboldalad bármely oldalának, ha hozzáadod a megfelelő kódot. Elsősorban a kisebb cégek tesztelő eszköze.

AB Tasty

Olyan márkák használják az AB Tastyt, mint a Sephora, az Ugg vagy a Carrefour. Az A/B tesztek mellett multivariációs teszteket, adatelemzéseket, marketing-eszközöket is kínál. A célzás finoman állítható URL, hely, időjárás, stb. alapján.

Freshmarketer

A Freshmarketer a Freshwork üzleti platform marketinges leágazása, mely A/B tesztek és split tesztek készítésére ad lehetőséget. Integrálható a Google Analyticsszel. Amennyiben valamely verzió jobban teljesít, mint a többi, azt élesíti.

Convert

A Convert is egy A/B tesztelő és perszonalizációs eszköz, melyet olyan cégek használnak, mint a Sony, vagy olyan szervezetek, mint a Unicef. Lehetővé teszi a felhasználók szegmentálását viselkedésük, cookie-k, JavaScript-események alapján.

És néhány WordPress plugin A/B tesztelésre

Simple Page Tester

A Simple Page Tester eléggé le tudja egyszerűsíteni különböző verziók hatékonyságának összehasonlítását. Ez egy könnyen használható WordPress plugin a kezdők számára, mely nem igényel semmiféle kódolási tudást. És amiatt sem kell aggódnod, hogy negatívan befolyásolná a rangsorolásod. Az eszköz segítségével követheted az egyedi látogatók alakulását minden variáció esetében, de ha további információkra lenne szükséged, akkor meg kell venned a prémium verziót. Található benne konverziókövetés és automatikus statisztikai megbízhatósági kalkulátor is.

Thrive Headline Optimizer

A Thrive Headline Optimizer elsősorban azt mutatja meg, hogy melyik címsorod kelti fel a látogatóid figyelmét. A plugin méri az átkattintásokat a blogoldaladon, így a használatával növelheted a látogatók és csökkentheted a visszafordulók arányát.

Calls to Action

A konverziókhoz nem elég egy jó címsor, ami az oldalra viszi a látogatót, kell hozzá egy hatékony call to action is, mely vevővé változtatja. Azt viszont nehéz kitalálni, hogy a Te közönséged esetében milyen CTA működik a legjobban. Tesztelni kell, erre pedig megfelelő eszköz lehet a Calls to Action plugin, melyel CTA-k adhatók az oldaladhoz, és vizsgálható a hozzájuk kapcsolódó konverziós arány.

Split Hero

A Split Hero lehetőtvé teszi számodra, hogy a weboldaladnak akár négy különféle verzióját is létrehozd és teszteld. Az eszköz használható a WordPress szerkesztőn vagy egy page builderen belül is. Csak kapcsold össze a plugint az oldaladdal, töltsd ki a kampányra vonatkozó részleteket, és indulhat a tesztelés. Minden kampány végén látni fogod, hogy melyik verzió teljesített a legjobban.

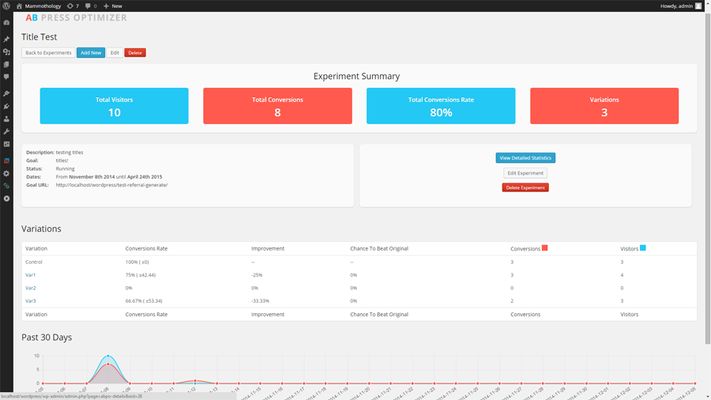

AB Press Optimizer

Az AB Press Optimizer segítségével annyi verziót tesztelhetsz, amennyit csak akarsz, és valós idejű adatokat kapsz tőle.

SEO A/B Split Testing

A SEO A/B Split Testing elsősorban azt tudja, hogy a blogposztjaid címét, címsorát, meta leírását, tehát a SEO szempontból fontos részeket optimalizálja. Segít abban, hogy létrehozz új variációkat, és megállapítsd, hogy melyik, hogy teljesít a Google keresőjében. Azért lehet hasznos, mert egy költséges tartalmi kampány elindítása helyett megvizsgálhatod, hogy néhány kisebb, és olcsóbb változtatástól milyen hatás várható.

9. Egyidejűleg teszteld a két variációt!

Az idő fontos szerepet játszik a marketingkampányod eredményeinél, hiszen befolyásolja az eredményeket az, hogy mely hónapban, napon, napszakban végzed a tesztet. Hibás következtetésekhez vezethet, ha az egyik verziót az egyik hónapban, majd a másik verziót a következő hónapban vizsgálod. A két variációt lehetőleg azonos időpontban kell tehát futtatni. Kivételt jelent persze, amikor magának az időpontnak a hatékonyságát teszteled, tehát például azt, hogy mikor a legjobb kiküldeni egy e-mailt.

10. Elegendő ideig futtasd a tesztet!

Ahhoz, hogy megfelelő mintaméretet kapj, elegendő ideig kell zajlania a tesztjeidnek. Ha nem megfelelő méretű a minta, akkor nem tudod megmondani, hogy statisztikailag szignifikáns-e az eltérés a két variáció között. De milyen hosszú időtartam a megfelelő? Ez függ attól, hogyan hajtod végre az A/B tesztet és mit tesztelsz. Lehet néhány óra vagy akár több hét is, míg megfelelő eredményekhez jutsz. Tehát, ha a weboldaladnak alacsony a látogatószáma, akkor hosszabb ideig fog tartani a teszt elvégzése.

11. Kérj visszajelzés a felhasználóktól!

Az A/B tesztek során mennyiségi adatokkal dolgozol. Ezek azonban nem feltétlenül magyarázzák meg számodra a miértet. Az A/B tesztek során tehát érdemes kvalitatív információkat is beszerezni, azaz megkérdezni az embreket, hogy mi a véleményük. Elhelyezhetsz például egy kilépő kérdőívet a weboldaladon, ahol megkérdezed az emberektől, hogy miért nem kattintottak a CTA-ra, illetve a köszönő oldalon azt kérdezed meg tőlük, hogy miért kattintottak rá.

Az A/B teszt után

12. Koncentrálj a cél-mutatóra!

Habár nyilván több dolgot is mérsz egyszerre, mégis ki kell választanod egy mutatót, ami a legfontosabb számodra. Ezt még a teszt előtt meg kell tenned. Tehát, ha egy e-mail tesztnél a konverziós arányt választottad, mint elsődleges mutatót, akkor a teszt után már ne a megnyitási és az átkattintási aránnyal kezdjél foglalkozni. Lehet, hogy azt fogod látni, hogy gyenge az átkattintási arány, de jó a konverzió, mégis azt a verziót kell választanod, mely jobb konverziós arányt hozott.

13. Állapítsd meg, hogy szignifikánsak-e az eredmények!

Itt jöhetnek a számítások, de az interneten találsz hozzá szignifikancia kalkulátorokat A/B tesztekhez. Például használhatod ezt, mely a 90 százaléknál nagyobb bizonyosságot tekinti statisztikailag szignifikánsnak. Csak be kell írnod a próbálkozások számát, tehát például az oldallátogatókét vagy a kiküldött e-mailekét, majd a konverziók számát, például egy adott CTA-ra kattintókét, és megállapítja, hogy bízhatsz-e az eredményekben.

14. Cselekedj a kapott eredmények alapján!

Ha statisztikailag szignifikáns eredményt kaptál, akkor láthatod, hogy melyik verzió teljesített jobban. Vedd használatba a jobban teljesítő verziót! Ha azt látod, hogy statisztikailag egyik verzió sem tekinthető jobbnak a másiknál, akkor maradj az eredeti verziónál, mert nincs értelme módosítanod. Vagy pedig futtass egy újabb tesztet nagyobb mintával. De minden egyes tesztnél rá fogsz jönni olyan dolgokra, melyeket később is felhasználhatsz.

15. Végül, tervezd meg a következő tesztet!

Az éppen befejezett A/B teszt segít abban, hogy miként teheted hatékonyabbá a marketingedet. Itt azonban ne állj meg, hiszen mindig van lehetőség további optimalizálásra! Ha változtattál egy szövegen, utána jöhetnek a színek vagy a képek. Mindig gondolkozz, hogy milyen lehetőségek merülnek fel, melyekkel esetleg javíthatod a konverziós arányod és a vevőid számát!

Milyen elemeket érdemes tesztelni egy weboldalon?

Annak nincs sok értelme, hogy véletlenszerűen rábökj egy-egy elemre a weboldaladon, melyet szerinted tesztelni kellene. Ha már megvan a cél, akkor keress hozzá egy eszközt, vagyis egy tesztet az alábbiak közül:

Tipográfia-tesztek

Lehet, hogy nem hiszed, de a weboldaladon alkalmazott betűtípusok is befolyásolják a konverziós arányt. Természetesen annak nincs értelme, hogy elkezdd valamennyi betűtípust letesztelni, hogy vajon melyik hozza a legjobb eredményeket. A tipográfiának azonban van néhány olyan jellemzője, melyet érdemes tesztelni a betűtípusok előtt.

Így például azt, hogy serif vagy sans serif betűt használj. A kettő közötti különbségről a betűtípusokról szóló anyagunkban írtunk, amiből kiderül, hogy nem mindegy melyiket választod.

A másik lehetőség a színek vizsgálata. Alapvetően persze fekete-fehér párosítást – vagy legalábbis valami ahhoz közel állót – érdemes használni a szövegtörzs esetében, azonban akadnak egyéb szöveges részek is egy weboldalon, így például a CTA-k, ahol már érdemes megnézni egy-két színt, hogy akad-e közöttük olyan, amelyik jobban teljesít a többinél.

További lehetőség a betűméretek tesztelése, hiszen befolyásolja az olvashatóságot, és hatással lehet a kattintásokra is a méret. Ráadásul minden betűtípusnál más méret lehet a megfelelő, így érdemes tesztekkel megállapítani, hogy melyik méret a legjobb választás.

Végül pedig lehet tesztelni az egyes betűtípusokat, de természetesen nem kell a teljes kínálatot tesztelni, csak néhány típust, melyeket eleve jónak tartasz a weboldaladon, ami passzol a designhoz.

Mit érdemes tesztelni a CTA-kon?

A legfontosabb elem egy landing oldalon a CTA, így ha mást nem is, ezt mindenképpen érdemes tesztelni. De milyen lehetőségek vannak a CTA-knál? Például tesztelhető a CTA-k elhelyezése. Az, hogy a hajtás felett, az oldal közepén vagy a végén, jobb oldalon vagy a bal oldalon a leghatékonyabb. Az ugyanis nem mindig egyértelmű, az adott landing oldaltól, terméktől, tartalomtól függ, hogy mikor, milyen elhelyezés működik a legjobban.

A legtöbb weboldaltulajdonosnak a szín jut elsőként eszébe, ha CTA-tesztelésről van szó. Valóban rendkívül fontos, hogy milyen a színe a CTA-nak. Az ugyanis nem elég, ha kontrasztos, hiszen weboldaltól függ, hogy milyen szín illeszkedik hozzá, és melyik teljesít a legjobban. Ezért nem érdemes arra alapozni, hogy másoknak mi jött be, főleg, hogy különböző tesztek különböző eredményeket hoznak.

És hát nyilván a CTA szövegét is érdemes tesztelni, mivel ez a legfontosabb szöveg-rész a weboldaladon. Különböző hosszúságokat, mondatokat, szavakat kell kipróbálni, hogy melyik bírja leginkább kattintásra a látogatókat.

Szöveg tesztelése

Egy weboldalnak fontos része a szöveges tartalom, ami elsőre nem feltétlenül sikerül a leghatékonyabbra. A maximális hatás eléréshez érdemes többféle verzióval megpróbálkozni.

Egyrészt érdemes megnézni, hogy rövidebb vagy hosszabb szöveg előnyös a látogatóidnak. Az elmélet szerint persze a rövid a jobb, hiszen az emberek úgysem sokat olvasnak a weben, ráadásul elfér a hajtás felett. A rövid szöveg azonban nem minden esetben működik jól mások által elvégzett tesztek szerint. Hogy a Te esetedben mi a jobb, azt neked kellene megállapítani.

És természetesen maga a szöveg is fontos, de annak nyilván nincs értelme, hogy minden egyes szó megváltoztatását leteszteld. Ugyanakkor mindig érdemes fejleszteni, változtatni egy weboldal szövegein, és ilyenkor letesztelni, hogy az új verzió előnyös változást hozott-e a konverziót tekintve.

Emellett pedig azt is érdemes lehet megvizsgálni, hogy szöveges tartalom helyett a Te esetedben nem működik-e jobban egy videó.

A vizuális design további elemeinek tesztelése

Az előbbieken túl akadnak még olyan részletei minden designnak, amit érdemes teszt alá vetni. Ilyen lehet például az, hogy milyen képeket, háttereket használsz a weboldalon. Hiszen ezek befolyásolják a látogatók hozzáállását az oldaladhoz.

Érdemes megnézni, hogy a linkek és a menük hatékonyak-e, szükség van-e rájuk, vagy rontják a teljesítményét a landing oldaladnak. Érdemes megnézni a számukat, az elhelyezésüket, színüket, stb.

Az űrlapok sem elhanyagolható fontosságú elemei egy weboldalnak, ahogy arra az űrlapokról szóló anyagunkban már rávilágítottunk. Habár itt a kevesebb több elv érvényesül, érdemes azért vizsgálgatni, hogy mi az elfogadható mező-szám a felhasználók számára, milyen elrendezés a leghatékonyabb.

Árral kapcsolatos elemek tesztje

Itt nem arról van szó, hogy az árakat teszteld, hanem – már ha alkalmazható a termékedhez vagy szolgáltatásodhoz – például arról, hogy érdemesebb-e ingyenes próbát vagy garanciát ajánlanod. Esetleg azt megvizsgálni, hogy milyen hosszúságú legyen egy próbaidőszak. És persze magukat az árajánlatokat is érdemes lehet tesztelni, ha használsz ilyet.

Milyen gond lehet az A/B tesztekkel?

Az A/B teszteknél a kérdés elsősorban az, hogy van-e értelme, hoz-e valós eredményt egy-egy teszt? Valóban egy A/B teszt tud segíteni az oldaladon? Elegendő az, hogy arra figyelsz milyen színű a CTA-d, ahelyett, hogy jobbá tennéd a terméked?

Sok esetben nem elegendő, mert a gond nem egy CTA színével van, hanem sokkal mélyebben. Vagyis nem azért nem osztják meg mondjuk a tartalmad az emberek, mert rossz a CTA-d, hanem azért, mert gyenge a tartalom. Ráadásul az is lehet, hogy nem is annak kellene a célodnak lenni, hogy minél több kattintást érj el, hanem például az, hogy bizalmat építs.

Az AppSumo vizsgálata szerint mindössze az A/B tesztek 10 százalékának eredményeként kerül sor változtatásokra a weboldalakon. A teszteket elvégzők a tesztek felénél nem hoztak döntést a nem meggyőző vagy rosszul mért adatok miatt. Az oka ennek az, hogy a cégek túl gyakran, de túl rövid ideig futtattak A/B teszteket.

Figyelembe kell venned, hogy a szín megváltoztatása, a call to action szövege vagy a weboldal felépítése csak minimális hatással lehet a kulcsfontosságú adatokra. Ráadásul, ha ezek megváltoztatásával javítasz is a számokon, ezek valószínűleg csak rövid életűek. Folyamatos növekedést ugyanis nem egy kékről pirosra módosított gomb fog eredményezni, hanem egy olyan termék kialakítása, melyet szeretnek használni az emberek.

Vagyis arra kell törekedned, hogy több értéket adj, és javítsd a felhasználói élményt! Mindig gondolj arra, hogy nem feltétlenül egy gomb színe miatt nem jönnek az eredmények. Lehet, hogy javítanod kell a terméken vagy a funkción, amit kínálsz az embereknek

Ha azt állapítod meg egy A/B teszt során, hogy az A verzió 20 százalékos konverziós arányt hoz, míg a B verzió 22 százalékot, akkor nincs túl sok értelme ez alapján bármit is módosítani a weboldaladon. Figyelj arra, hogy az adatok statisztikailag szignifikánsak legyenek! Emiatt érdemes a teszteket minél hosszabban futtatni, hiszen annál megbízhatóbb adatokat kapsz. Annak nincs értelme, hogy egy néhány napos teszt határozza meg a weboldalad kinézetét az elkövetkező évekre.

A hatékony A/B tesztek révén megoldod az emberek problémáit. Ezek hosszú távú, értékes változásokat eredményeznek a felhasználók számára. Ha viszont megalapozatlan vizsgálatokra építed a weboldalad, azzal valójában nem tartasz semerre. Tehát olyan dolgokat tesztelj, melyeknek jelentőségük van, figyelj a valódi visszajelzésekre, és megfelelő ideig futtasd a teszteket! Adj ezáltal valódi értéket a felhasználóidnak és ne a színárnyalatokkal játssz!

Természetesen fontos, hogy a weboldalad felépítése jó legyen, a szövegek hatékonyak, az információs architektúra pedig jól használható. Ugyanakkor az is fontos, hogy ténylegesen javíts a felhasználói élményen és oldd meg a weboldaladdal kapcsolatos problémákat, ne csak úgy tegyél, mintha ezt csinálnád!

Miért nem érdemes a kisebb weboldalakat A/B tesztelni?

Habár az elmélet szerint bármely weboldaldal esetében annak minden elemét javasolt tesztelni – hiszen mindig létezhet egy hatékonyabb verzió -, a gyakorlat azt mutatja, hogy sok esetben nem érdemes A/B teszteket használni. Matt Isherwood egy blogbejegyzésben összefoglalta az okokat.

Túl sok idő

Habár a statisztikai szignifikanciát általában minden szoftver és tesztelő személy figyelembe veszi, ugyanakkor a statisztikai erővel, mint tényezővel már nem foglalkoznak. Ez azt jelenti, hogy jelentős forgalom kell ahhoz, hogy a teszt eredményeit érdemes legyen figyelembe venni.

Az Optimizely mintaméret kalkulátorával könnyen kiszámolható, hogy ha mondjuk egy 5 százalékos konverziós arányt akarsz javítani 10 százalékkal, akkor 95 százalékos statisztikai szignifikancia mellett változatonként 31 ezer felhasználóra van szükség, ami két változat esetében már 62 ezer egyedi felhasználót jelent. Ez pedig egy kis weboldal esetében elég jelentős szám, és hónapokig tart, mire eléri. Arról nem beszélve, hogy ha kisebb változások is érdekesek számára a konverziós arányt illetően, akkor már egy-két százalékpontos csökkenés is óriási mértékben megnöveli a szükséges minta méretét.

Ez kisebb forgalmú weboldalaknál egyszerűen nem működik, különösen akkor nem, ha egy induló weboldalról van szó, ahol néhány héten belül fontosak az eredmények, és nagyon sok minden változik a kezdeti időszakban. A fejlesztők nem igazán várhatnak hónapokig, hogy hozzányúljanak az oldalhoz, mert arra már előbb szükség lesz.

Ha pedig túl hamar leállítják a tesztet, akkor hibás eredmények születnek, melyekre nem lehet alapozni az optimalizálást. Ilyenkor lehet azzal találkozni, hogy a valóság nem igazolja a teszt eredményeit.

Ráadásul az is torzítja az eredményeket, hogy a teszt közben elindít a cég egy hirdetési kampányt, mely által hirtelen megváltozik a felhasználók összetétele, és ők talán egészen máshogy viselkednek, mint a megszokott forgalom.

Nincs meg a szakértelem

A statisztikai szignifikancia és a statisztikai erő csak a kezdete a dolgoknak, melyeket figyelembe kell venni A/B tesztek futása során. Számos olyan fogalom kapcsolódik még a teszteléshez, mely teljesen ismeretlen a webdesignerek vagy a marketingesek számára is. Persze, a szoftverek leegyszerűsítik az A/B teszteket, azonban ha nem ismered a mögötte lévő matekot, akkor jó esély van arra, hogy hibásak lesznek a következtetések. Még akkor is, ha a statisztikai szignifikancia eléri a 95 vagy akár a 99 százalékot.

A statisztikai szignifikancia ráadásul sokak szerint nem is jelent túl sokat, ezért van az, hogy akadnak olyan tudományos kiadványok, ahol nem is tekintik olyan tényezőnek, melynek bármiféle jelentősége lenne. Egy jól kivitelezett A/B teszt eredményeinek értelmezéséhez bizony adat-szakemberekre van szükség.

Akadnak jobb megoldások

A kis és közepes méretű cégek weboldalai esetében az A/B tesztek helyett valószínűleg hatékonyabbak a felhasználói tesztek. Amikor felhasználói teszteket végzel, akkor olyan új adatokkal fogsz találkozni a felhasználók valós feladatvégzése révén, melyekhez máshogy nem juthatsz hozzá. Ráadásul, míg egy A/B teszt csak egyetlen oldalról, illetve annak egyetlen eleméről mond el neked valamit, addig egy jól kivitelezett felhasználói teszt a weboldal egészéről, annak használatáról véleményt mond.

Ráadásul egy felhasználói tesztnél nem kell törődni a statisztikai szignifikanciával, hiszen kvalitatív tesztről van szó. Tehát, ha az általad megkérdezett emberek közül akár csak egy-kettő nem találja például a keresőmezőt a weboldaladon, akkor tudod, hogy annak megjelenítésével valami probléma van. Az, ahogy látod az embereket használni a weboldalad, sokkal többet elárul annak hatékonyságáról, mint bármennyi szám.

Ráadásul nem is kell hozzá a rengeteg egyedi felhasználó, így már induláskor vagy akár a weboldal indulása előtt is megvizsgálhatod, hogy működik-e az oldal, azt adja-e a felhasználóknak, amire szükségük van. Mégpedig sokkal gyorsabban és könnyebben megmutatja ezt.

Mindez persze nem jelenti azt, hogy az A/B tesztek ne működnének vagy adott esetben ne lennének hatékonyak. Ha szakértők elemzik az adatokat nagy forgalmú weboldalakon, akkor fontos következtetések vonhatók le A/B tesztek által. De ha a Te weboldalad nem egy nagy forgalmú weboldal és nem adat-szakértők elemzik a tesztek eredményeit, akkor más megoldások lényegesen hatékonyabbak.

Hogyan A/B tesztelj, hogy az ne zavarja a Google-t?

Sok SEO-s és marketinges aggódik amiatt, hogy ha A/B tesztelsz egy weboldalt, akkor annak hátránya lehet a helyezésre nézve. Miért? Mert mi van akkor, ha a Google úgy értelmezi a tesztet, hogy „az egy spam”? Hiszen ilyenkor két majdnem azonos oldal jelenik meg, amit a Google duplikált tartalomnak tekinthet. Ráadásul a tesztoldalakat érdemes távol tartani az indexeléstől. A helyzet tehát nem egyszerű SEO szempontból. Mit lehet tenni?

A Google mindenesetre korábban már megfogalmazta, hogy az A/B tesztek olyan egyedi marketingmegoldások, melyek miatt nem büntet. Maga a Google Analytics is egy hasznos eszköz, ha A/B tesztekről van szó. A Google egyébként azt javasolja, hogy egyrészt:

- használjuk a rel=”caconical” címkét

- használjunk 302-es átirányítást

- csak annyit és csak annyi ideig kísérletezzünk, ameddig muszáj.

Az A/B tesztek ugyanis általában érintetlenül hagyják a tartalmat, és legtöbbször az egyes designelemeket hasonlítják össze. Ilyenkor előáll az a probléma, hogy van két azonos tartalmú oldalad, vagyis duplikált tartalmad. John Mueller, a Google szakembere már többször jelezte, hogy duplikált tartalom miatt nem büntet a Google. A hatása mindössze annyi, hogy a Google kiválaszt egy verziót, amit megjelenít a találati oldalakon.

Persze előállhat az a probléma is, amit „álcázásnak” hívunk. Vagyis mutatsz valamit a felhasználóknak, miközben valami mást mutatsz a Googlebotnak. A Google szerint viszont a Googlebotot úgy kell kezelni, mint bármely felhasználót. Vagyis, ha csinálsz egy A/B tesztet, akkor a bot vagy az A vagy a B verzióval találkozik. Ez nem okoz gondot.

Ugyanakkor a Google arra felhívja a figyelmet, hogy a túl hosszú ideig futatott tesztek már problémát jelenthetnek. Tehát, amikor már annyi ideig tart egy teszt, hogy már nem is igazán tekinthető tesztnek, hanem ez lesz a stabil állapota egy oldalnak. Azzal viszont nincs gond, ha egy weboldal folyamatosan tesztel: egy hónapig futtat egy verziót, majd módosít rajta és újabb egy hónapig vizsgálja azt is.